L’apprentissage entre neurosciences et intelligence artificielle

La rentrée 2018 a été marquée par l’importance accordée par le Ministre de l’éducation aux bases neuroscientifiques de l’apprentissage avec la nomination de Stanislas Dehaene, chercheur en sciences cognitives, à la présidence du Conseil scientifique de l’éducation. Un post de Prospectibles avait souligné l’importance des recherches de ce neuropsychologue dans la compréhension du phénomène de la lecture. Quant à l’’apprentissage profond’, il devient le nouveau défi de l’intelligence artificielle en démontrant la capacité d’entités informatiques (réseaux de neurones) de développer une sorte d’apprentissage en s’’entraînant’ à l’aide d’algorithmes qui s’auto-corrigent.

La rentrée 2018 a été marquée par l’importance accordée par le Ministre de l’éducation aux bases neuroscientifiques de l’apprentissage avec la nomination de Stanislas Dehaene, chercheur en sciences cognitives, à la présidence du Conseil scientifique de l’éducation. Un post de Prospectibles avait souligné l’importance des recherches de ce neuropsychologue dans la compréhension du phénomène de la lecture. Quant à l’’apprentissage profond’, il devient le nouveau défi de l’intelligence artificielle en démontrant la capacité d’entités informatiques (réseaux de neurones) de développer une sorte d’apprentissage en s’’entraînant’ à l’aide d’algorithmes qui s’auto-corrigent.

Ces deux programmes n’ont pas manqué de susciter des polémiques, notamment dans l’enseignement où les pédagogues ont souligné l’aspect multifactoriel de l’apprentissage qui ne se limite pas à un phénomène neurobiologique et comporte de nombreux facteurs sociaux. D’autres se sont inquiétés de l’utilisation de la notion d’intelligence pour désigner l’activité de super-programmes informatiques. Car ce qui manque encore à ces machine pensantes, c’est la dimension émotionnelle de l’intelligence, qui, contrairement à l’idée reçue cartésienne est un facteur important dans la cognition, comme le souligne Frédéric Duriez dans Thot Cursus. Et on est encore loin de « voir une machine pleurer » comme le prédit Yann Le Cun, chercheur en intelligence artificielle, dans une interview à 20 minutes. Ce spécialiste de l’apprentissage profond chez Facebook est d’ailleurs le co-auteur avec Stanislas Dehaene, d’un ouvrage sur l’histoire de intelligence, qui vient de paraître chez Robert Lafont.

La neuropédagogie, nouvelle tendance éducative

Pascal Roulois, enseignant et chercheur en neuropédagogie, la définit ainsi sur son site « la neuropédagogie est la rencontre entre la pédagogie et les sciences cognitives : neurosciences, psychologie, philosophie. Elle vise principalement à renforcer l’efficacité de l’apprentissage (intellectuel, manuel) et de l’enseignement en analysant et intégrant de nombreux paramètres, biologiques aussi bien que psychologiques. Discipline systémique qui fait le lien entre « l’ordinateur » (le cerveau) et les « logiciels » (connaissance, compétence, savoir, savoir-être, information…), son champ d’application est donc large. ». Dans ce texte de 2013, il rappelle que cette discipline puise dans une longue histoire et que des pédagogues comme Philippe Meirieu (qui critique aujourd’hui l’orientation actuelle de l’enseignement basée sur les neurosciences) et bien d’autres sont à l’origine de nombreux concepts de neuropédagogie … Philippe Meirieu reconnaît dans son ouvrage « Apprendre, oui mais comment ?« , l’importance des processus mentaux dans la progression de la compréhension. En effet, contrairement au modèle de cours habituel : identification (repérer des informations) – signification (comprendre les informations) – utilisation (résoudre des exercices), « Une information n’est identifiée que si elle est associée à un projet d’utilisation intégrée dans la dynamique du sujet et c’est ce processus d’interaction entre l’identification et l’utilisation qui est générateur de signification, c’est-à-dire de compréhension ».

Pascal Roulois reconnaît néanmoins dans un texte plus récent que « Les neurosciences bénéficient d’une aura exagérée, alors que bien souvent, elles ne remplissent pas les critères ordinaires que l’on applique aux autres sciences ». Il souligne aussi que « les neurosciences ont permis à l’intelligence artificielle de faire un bond technologique prodigieux, qui a été rendu possible grâce à l’observation du cerveau humain, si bien que les grands projets cherchent à fabriquer des neurones et synapses artificiels. Les retombées pratiques se mesureront très prochainement, y compris en matière d’apprentissage. ». Or la neuropédagogie est « fondamentalement pluridisciplinaire » : elle est « formée de neurosciences, mais aussi de psychologie, plus particulièrement de psychologie de l’éducation et de psychologie cognitive ». D’où son importance dans la compréhension du phénomène de l’apprentissage.

Ce que les neurosciences nous apprennent, c’est qu’il existe deux modes d’apprentissage, avec ce que Rémy Sussan, citant l’ouvrage de Barbara Oakley dans Internet Actu, appelle le ‘paradoxe de la créativité’. « Autrement dit, lorsqu’on cherche à résoudre un problème, la partie du cerveau qui y travaille n’est pas celle qui trouve la solution ». Selon la chercheuse, le cerveau fonctionne sur deux modes : le ‘diffus’ et le ‘concentré’. Le mode concentré suit un cheminement logique en enchaînant les associations d’idées claires et évidentes ; le mode diffus est celui de l’inconscient où notre train de pensées associe les idées les plus éloignées. C’est à ce moment-là, devant un problème inédit ou difficile que nous avons besoin de nouvelles connexions entre nos neurones. Ces deux modes sont complètement liés et complémentaires « En fait, l’inconscient, le mode diffus, n’est capable que de résoudre les questions sur lesquelles le mode concentré a intensément travaillé auparavant. »

Mais comme le souligne, Michel Lussault, ancien Président du Conseil supérieur des programme, cité dans Libération, «Les élèves ne sont pas juste des cerveaux dans des bocaux. Il y a une interaction permanente entre le corps, le cerveau et l’environnement ». Cela explique l’appel du syndicat du primaire Sniupp, cosigné par 60 chercheurs pour alerter l’opinion et mettre en garde le Ministre « Un conseil scientifique, oui, mais représentant toute la recherche… Dans le dialogue permanent que l’école doit entretenir avec la recherche, aucune discipline ne peut légitimement s’imposer aux autres et aucune ne doit être ignorée. La recherche ne peut être instrumentalisée dans des débats médiatiques le plus souvent réducteurs. ». C’est cette position que défend vigoureusement le psychologue Luc-Laurent Salvador dans Agoravox. Face à S. Dehaene affirmant dans l’ouvrage Apprendre à lire : des sciences cognitives à la salle de classe, que les enseignants doivent « devenir experts de la dynamique cérébrale », L.L. Salvador rappelle que « le cerveau est le produit de l’activité humaine et non pas l’inverse ». C’est à travers de la répétition, de l’entraînement des activités de fonctions corporelles et mentales qui « en viennent à imposer leur trace sur le substrat neural et donc à déterminer l’organisation cérébrale la plus favorable à leur exécution jusqu’à en permettre l’automatisation. ». Pour lui, l’important n’est pas ce qui se trouve dans la boite (crânienne) et que nous dévoile l’imagerie médicale, mais ce qui se trouve à l’extérieur « là où s’accomplit l’activité : le corps, l’esprit, les autres, le monde. ». S’il reconnaît que le cerveau joue « un rôle indispensable consistant, d’une part, à permettre des coordinations internes entre nos cycles perception-action puis, d’autre part, à les conserver (comme la pâte à modeler) », pour ce professionnel, les neurosciences ont un apport pédagogique nul, n’apportant que « de simples confirmations de ce que l’on savait déjà ». Comme le souligne l’épistémologue et neurophysiologiste André Giordan dans un post d’Educavox, « la crédibilité des neurosciences n’est pas assurée sur le plan de l’éducation, les preuves de leur efficacité sont souvent fragiles ou même absentes. Les arguments avancés reposent sur des études rarement corroborées sur le terrain et comportant nombre de biais conceptuels et méthodologiques ». Il donne comme exemple la condamnation de la méthode globale en lecture. Alors que pour Dehaene « ceux qui ont une méthode alphabétique, phonique entraîne le circuit de l’hémisphère gauche qui est le circuit universel, efficace de la lecture. Les personnes qui ont une attention globale, la forme du mot, ces personnes n’utilisent pas ce circuit. Leur attention est orientée vers l’hémisphère droit qui est un circuit beaucoup moins efficace pour l’analyse de la lecture ». Pour lui, « tout autre circuit d’apprentissage éloigne l’enfant de la lecture ». Pour Giordan, en revanche, « Le processus d’apprentissage de la lecture chez chaque enfant est unique, il dépend essentiellement de son désir d’apprendre à lire et du contexte qui le favorise… ».

Mais comme le souligne, Michel Lussault, ancien Président du Conseil supérieur des programme, cité dans Libération, «Les élèves ne sont pas juste des cerveaux dans des bocaux. Il y a une interaction permanente entre le corps, le cerveau et l’environnement ». Cela explique l’appel du syndicat du primaire Sniupp, cosigné par 60 chercheurs pour alerter l’opinion et mettre en garde le Ministre « Un conseil scientifique, oui, mais représentant toute la recherche… Dans le dialogue permanent que l’école doit entretenir avec la recherche, aucune discipline ne peut légitimement s’imposer aux autres et aucune ne doit être ignorée. La recherche ne peut être instrumentalisée dans des débats médiatiques le plus souvent réducteurs. ». C’est cette position que défend vigoureusement le psychologue Luc-Laurent Salvador dans Agoravox. Face à S. Dehaene affirmant dans l’ouvrage Apprendre à lire : des sciences cognitives à la salle de classe, que les enseignants doivent « devenir experts de la dynamique cérébrale », L.L. Salvador rappelle que « le cerveau est le produit de l’activité humaine et non pas l’inverse ». C’est à travers de la répétition, de l’entraînement des activités de fonctions corporelles et mentales qui « en viennent à imposer leur trace sur le substrat neural et donc à déterminer l’organisation cérébrale la plus favorable à leur exécution jusqu’à en permettre l’automatisation. ». Pour lui, l’important n’est pas ce qui se trouve dans la boite (crânienne) et que nous dévoile l’imagerie médicale, mais ce qui se trouve à l’extérieur « là où s’accomplit l’activité : le corps, l’esprit, les autres, le monde. ». S’il reconnaît que le cerveau joue « un rôle indispensable consistant, d’une part, à permettre des coordinations internes entre nos cycles perception-action puis, d’autre part, à les conserver (comme la pâte à modeler) », pour ce professionnel, les neurosciences ont un apport pédagogique nul, n’apportant que « de simples confirmations de ce que l’on savait déjà ». Comme le souligne l’épistémologue et neurophysiologiste André Giordan dans un post d’Educavox, « la crédibilité des neurosciences n’est pas assurée sur le plan de l’éducation, les preuves de leur efficacité sont souvent fragiles ou même absentes. Les arguments avancés reposent sur des études rarement corroborées sur le terrain et comportant nombre de biais conceptuels et méthodologiques ». Il donne comme exemple la condamnation de la méthode globale en lecture. Alors que pour Dehaene « ceux qui ont une méthode alphabétique, phonique entraîne le circuit de l’hémisphère gauche qui est le circuit universel, efficace de la lecture. Les personnes qui ont une attention globale, la forme du mot, ces personnes n’utilisent pas ce circuit. Leur attention est orientée vers l’hémisphère droit qui est un circuit beaucoup moins efficace pour l’analyse de la lecture ». Pour lui, « tout autre circuit d’apprentissage éloigne l’enfant de la lecture ». Pour Giordan, en revanche, « Le processus d’apprentissage de la lecture chez chaque enfant est unique, il dépend essentiellement de son désir d’apprendre à lire et du contexte qui le favorise… ».

L’apprentissage profond : quand la machine s’autonomise

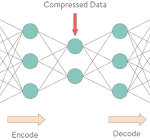

Jusqu’à récemment, l’informatique permettait aux humains de programmer des machines, aujourd’hui l’intelligence artificielle s’inspire du fonctionnement du cerveau, avec des réseaux de neurones artificiels. Le réseau est constitué de dizaines ou de centaines de couches de neurones, chacune recevant et interprétant les informations de la couche précédente, d’où le nom d’apprentissage profond (deep learning). On retrouve des « interprétations du traitement de l’information et des modèles de communication du système nerveux, à l’image de la façon dont le système nerveux établit des connexions en fonction des messages reçus, de la réponse neuronale et du poids des connexions entre les neurones du cerveau » (Wikipedia). Elles concernent plusieurs champs d’application : la reconnaissance visuelle et vocale, la vision par ordinateur, le traitement automatisé du langage, etc. (voir les exemples dans le post de Prospectibles sur l’IA) Ces systèmes ont des principes sous-jacents qu’ils partagent avec l’intelligence humaine et animale. Comme le soutient Yann Le Cun dans son interview à 20 minutes, « De même que l’aérodynamique explique à la fois comment volent les avions et les oiseaux. Les avions sont, d’une certaine manière, inspirés des oiseaux. Ils utilisent les mêmes principes sous-jacents mais ils n’ont pas de plumes ni de muscles ». Parmi ces principes, on trouve l’apprentissage. Le bébé, comme le petit animal, apprend des modèles du monde par observation, il apprend à suivre un visage, à détecter des mouvements ou qu’un objet peut être caché. Pour le moment, cet apprentissage est impossible à reproduire pour les machines. En matière d’apprentissage de modèles, on a d’abord eu l’apprentissage supervisé : « on donne l’image d’un chien à la machine et on lui dit ‘c’est un chien’. On lui donne la réponse. L’autre forme d’apprentissage, c’est l’apprentissage par renforcement, On laisse la machine faire des essais et des erreurs et, elle se corrige toute seule. ». Mais alors que dans un jeu vidéo, un humain met un quart d’heure pour atteindre un certain niveau de performance, il faut une centaine d’heure à une intelligence artificielle ! C’est aussi ce que constate Rémi Sussan, citant un article de la Technology Review dans InternetActu : « C’est pourquoi depuis les travaux de Hinton les progrès en IA ont été plus le fait de l’ingénierie (voire, nous dit le magazine, du « bricolage » ) que de la science proprement dite. On ajoute tel ou tel perfectionnement à l’algorithme, et on procède par essai et erreur. » Pour créer une véritable intelligence artificielle, analogue à celle des humains, il faudrait la doter de ‘sens commun’, d’une connaissance du monde.

Si nous arrivons à apprendre plus vite, selon Le Cun, c’est que nous avons un modèle prédictif du monde : on sait que si on tombe d’une falaise, ce sera fatal ! « Ce qui nous manque, c’est de permettre aux machines d’apprendre ces modèles prédictifs. Et on se heurte au même problème : le monde n’est pas entièrement prédictible… ». Les tâches des systèmes intelligents autonomes ne seront pas définies par des programmes, mais par des systèmes de valeurs. « Ce qui définit la tâche de ce robot, ce sera : aide l’humanité de telle manière. Un but très général. La machine définira elle-même les moyens par lesquels elle remplira ses pulsions et son système de valeurs. ». Nos pulsions « sont un système de valeurs précâblé dans notre cerveau. C’est lui qui nous dit qu’il faut respirer, manger, se reproduire. Comment va-t-on construire des machines autonomes ? En déterminant ces pulsions, ces systèmes de valeurs, de manière à ce que leur comportement s’aligne avec les valeurs humaines. ».

Si nous arrivons à apprendre plus vite, selon Le Cun, c’est que nous avons un modèle prédictif du monde : on sait que si on tombe d’une falaise, ce sera fatal ! « Ce qui nous manque, c’est de permettre aux machines d’apprendre ces modèles prédictifs. Et on se heurte au même problème : le monde n’est pas entièrement prédictible… ». Les tâches des systèmes intelligents autonomes ne seront pas définies par des programmes, mais par des systèmes de valeurs. « Ce qui définit la tâche de ce robot, ce sera : aide l’humanité de telle manière. Un but très général. La machine définira elle-même les moyens par lesquels elle remplira ses pulsions et son système de valeurs. ». Nos pulsions « sont un système de valeurs précâblé dans notre cerveau. C’est lui qui nous dit qu’il faut respirer, manger, se reproduire. Comment va-t-on construire des machines autonomes ? En déterminant ces pulsions, ces systèmes de valeurs, de manière à ce que leur comportement s’aligne avec les valeurs humaines. ».

L’adoption du processus d’apprentissage profond, inspiré des neurosciences cognitives, a permis aux intelligences artificielles de réaliser des avancées considérables dans de nombreux domaines. Mais ces systèmes logiciels sont encore loin d’avoir acquis l’autonomie nécessaire pour se « libérer » de la direction humaine. Si ces « machines pensantes » ne sont pas encore aux portes du pouvoir, les humains disposant de ces intelligences ‘étendues’ risquent de ne pas toujours en faire un bon usage, comme le craint le sociologue Eric Sadin dans son ouvrage sur l’IA analysé par Claire Chartier dans l’Expansion …

Chartier, Claire. – La face (très) noire de l’intelligence artificielle. – L’Express L’Expansion, 25/10/18

Droit, Roger-Pol. – Figures Libres. Ainsi naquit la vérité artificielle. – Le Monde, 25/10/18

Le Cun, Yann ; Beaudonnet, Laure. – Intelligence artificielle : « Dans le futur, on pourrait voir une machine pleurer. – 20 Minutes, 23/10/18

Sadin, Eric. – L’intelligence artificielle ou l’enjeu du siècle : anatomie d’un antihumanisme radical. – Paris : l’Echappée, 19/10/18

Dehaene, Stanislas ; Le Cun, Yann ; Girardon, Jacques. – La plus belle histoire de l’intelligence – Des origines aux neurones artificiels : vers une nouvelle étape de l’évolution. – Paris : Robert Laffont, 18/10/2018

Duriez, Frédéric. – Est-ce bien raisonnable d’être rationnel ? – Thot Cursus, 08/10/18

Apprendre ! Les talents du cerveau, le défi des machines/Stanislas Dehaene, dir. – Paris : Odile Jacob, 05/09/18. (Sciences)

Johnson, Sydney. – What can machine learning really predict in Education? – EdSurge News, 25/09/18

Moragues, Manuel. – Le premier livre traduit par une IA est… un manuel de deep learning. – L’Usine nouvelle, 12/09/18

Pédagogie et neurosciences, les limites et les réussites : dossier. – La Recherche n°539, Septembre 2018.

Taddei, François ; Peiron, Denis. – « Transmettre les compétences clés du XXIe siècle » : entretien. – La Croix, 31/08/18

Beard, Alex. – How babies learn and why robots can’t compete. - The Guardian, 03/04/18

Roulois, Pascal. – Qu’est-ce que la neuropédagogie ? – Xos, 08/02/18

Salvador, Luc- Laurent. – Au secours, la neuropédagogie est au pouvoir ! – Agoravox, 25/01/18

Piquemal, Marie. – Un conseil scientifique en éducation, pourquoi faire ? – Libération, 10/01/18

Cariou, Gautier. - L’apprentissage profond bouleverse les sciences. – La Recherche, n°529, Novembre 2017

Sussan, Rémi. – Les limites du deep learning et comment les dépasser. – Internet Actu, 24/10/17

Giordan, André. – Apprendre à lire ? … – Educavox, 29/08/17

Le plaisir d’apprendre/Philippe Meirieu et col. – Paris : Autrement, 2014