Humanités numériques : nouvelle discipline ou méthodologie des Sciences humaines et sociales ?

Comme le rappelait Etienne Cavalié (Lully) dans son post de Bibliothèques (reloaded) en janvier 2015 « le concept d’humanités numériques est vraiment en train de se répandre » depuis quelques années. Mais que représente cette notion qui prend de plus en plus de place dans le champ des sciences humaines et sociales (SHS) ? L’annonce d’une série « Humanités numérique » au baccalauréat général de même que la création d’un Executive Master Digital Humanities à Sciences Po interroge encore plus sur la place de cet objet ‘technoscientifique’ …

Comme le rappelait Etienne Cavalié (Lully) dans son post de Bibliothèques (reloaded) en janvier 2015 « le concept d’humanités numériques est vraiment en train de se répandre » depuis quelques années. Mais que représente cette notion qui prend de plus en plus de place dans le champ des sciences humaines et sociales (SHS) ? L’annonce d’une série « Humanités numérique » au baccalauréat général de même que la création d’un Executive Master Digital Humanities à Sciences Po interroge encore plus sur la place de cet objet ‘technoscientifique’ …

Définition

« Les humanités numériques2 sont un domaine de recherche, d’enseignement et d’ingénierie au croisement de l’informatique et des arts, lettres, sciences humaines et sciences sociales.

Elles se caractérisent par des méthodes et des pratiques liées à l’utilisation des outils numériques, en ligne et hors ligne, ainsi que par la volonté de prendre en compte les nouveaux contenus numériques, au même titre que des objets d’étude plus traditionnels.

Les humanités numériques s’enracinent souvent d’une façon explicite dans un mouvement en faveur de la diffusion, du partage et de la valorisation du savoir. »

Dans cette définition de Wikipédia on retrouve les deux pôles de ce champ de connaissance : ‘un domaine de recherche et d’ingénierie’ où l’informatique s’intègre dans les sciences humaines grâce aux outils numériques. La définition ne se limite pas aux méthodes et pratiques que ces outils instaurent, mais souligne aussi « la volonté de prendre en compte nouveaux contenus numériques ». On voit dans cette acceptation un dépassement de l’opposition que notait Alexandre Moatti dans Bibnum en octobre 2014 où il soulignait « deux tendances […] : ceux qui pensent que les des DH sont d’abord et avant tout une pratique, un outil, à intégrer aux champs disciplinaires universitaires […] ; ceux qui pensent que ce doit être une théorie, une discipline … ». Le chercheur se rattache lui-même à la première tendance (méthode, outil) tout en reconnaissant que les deux acceptations puissent coexister.

C’est cette dimension transversale des HN, « ce carrefour, cette convergence entre savoirs et savoir-faire technologiques » qu’analyse Elydia Barret dans son mémoire ENSSIB. Pour elle, les « SHS et les disciplines littéraires et artistiques connaissent une mutation numérique ». Ce sont aussi bien « les méthodes et les modes de travail que les problématiques et les productions scientifiques qui évoluent sous l’effet de la généralisation du numérique ». On se trouve donc bien devant un nouveau domaine de recherche qui requiert des compétences aussi bien des chercheurs dans chaque discipline mais aussi d’autres professionnels de l’information : informaticiens mais aussi bibliothécaires/documentalistes, archivistes et autres gestionnaires de productions esthétiques et sémantiques (conservateurs de musées, iconographes, etc.). C’est l’objet de ce mémoire qui souligne l’importance de la coopération entre chercheurs et bibliothécaires « Les humanités numériques font appel à des problématiques et à des compétences familières aux bibliothèques ». C’est aussi le point de vue que défend Etienne Cavalié dans son Projet de mode d’emploi sur les Humanités numériques où il explique un projet de livre sur les HN réalisé par deux tandems chercheurs/bibliothécaires « Les chercheurs vont progressivement s’emparer des technologies et méthodologies comprises dans l’appellation d’humanités numériques «

De plus, comme le rappelle la définition de Wikipédia, les HN « s’enracinent souvent dans un mouvement en faveur de la diffusion, du partage et de la valorisation du savoir ». Ce mouvement des « Archives ouvertes », lancé par des collectifs de chercheurs à la fin des années 1990, a été soutenu, relayé et alimenté par des professionnels de la documentation.

Périmètre des Humanités numériques

Que recouvrent les HN et quelles sont les pratiques habituellement désignées par ces termes ?

- Numérisation et archivage électronique des différents objets concernés : textes, image, sons, etc.

- Edition électronique « open access » à travers des dépôts institutionnels comme HAL ou Spire à Sciences Po, mais aussi édition d’ouvrages et de revues en ligne à travers le portail Open Edition

- Constitution de corpus numériques : textes, images et son, soit par numérisation de documents existants, soit par recueil de documents ‘nativement numériques’ : sites web, réseaux sociaux, etc. Exemple : le corpus COP21 réalisé par le Médialab et la Bibliothèque de Sciences Po

- Capture, analyse et traitement des données numériques : traitement linguistique (TAL), fouille de textes, traitement de l’image et du son, etc.

- Représentation graphique et visualisation des données.

Comme le rappelle Elydia Barret dans son mémoire, l’utilisation d’outils informatiques pour traiter les humanités n’est pas si nouvelle, puisque, dès la fin des années 1940, le père Roberto Busa entreprend l’élaboration d’un index des œuvres de Saint Thomas d’Aquin avec l’aide des informaticiens d’IBM, soit 11 millions de mots ! Ces ‘Humanities Computing’ continuent dans les années 1960 à 1980 et concernent essentiellement le traitement linguistique de corpus de textes comme le Brown Corpus aux Etats-Unis où un million de mots sont sélectionnés pour représenter la langue américaine … Les humanités numériques se distinguent en effet de ses précurseurs par la diversité et l’hétérogénéité de leurs objets, aussi bien que des méthodes et des outils mis en œuvre.

Les HN : nouvelles méthodes ou discipline spécifique ?

Les HN : nouvelles méthodes ou discipline spécifique ?

Cette controverse continue de diviser les différents acteurs (chercheurs, ingénieurs, professionnels de l’information). Comme le souligne Laurence Monnoyer-Smith dans son article « Ouvrir la boite à outils de la recherche numérique » : « Si les méthodes numériques mobilisées dans le cadre de recherche en sciences humaines ne sont pas radicalement différentes, elles renouvellent toutefois les débats épistémologiques provenant du croisement entre informatique et SHS ». Elle cite à ce propos l’article de Noortje Marres qui défend la théorie d’une ‘redistribution’ des méthodes qui a lieu au sein de la recherche numérique. D’après cette auteure, « les outils numériques et les sources de données en ligne transposent sur le web des méthodes traditionnelles en SHS, tout en les adaptant aux nouvelles propriétés du support ». Les chercheurs adaptent donc ces méthodes et les modifient pour faire face à de nouveaux défis épistémologiques.

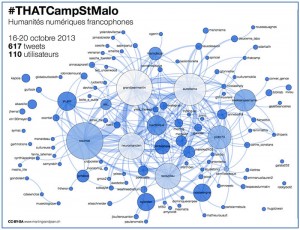

En revanche, le Manifeste des Digital Humanities (THATCAMP 2010) proclame « Les Digital Humanities désignent une transdiscipline, porteuse des méthodes, des dispositifs et des perspectives heuristiques liées au numérique dans le domaine des sciences humaines et sociales ». Les participants du Thatcamp ne négligent pas pour autant les méthodes traditionnelles « elles s’appuient sur l’ensemble des paradigmes, savoir-faire et connaissances propres à ces disciplines tout en mobilisant les outils et les perspectives singulières du champ du numérique ».

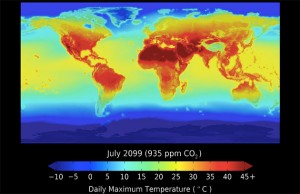

Il est indéniable que le numérique a changé notre rapport aux objets généralement étudiés par les humanités et les SHS. Par rapport à l’écrit par exemple, aussi bien la lecture que l’écriture connaissent une transformation par le numérique, grâce aux liens hypertexte et l’éditorialisation des contenus, sans oublier les groupes de lecture ou d’écriture en réseau … Quant aux pratiques sociales, elles ont été ‘cannibalisées’ par les outils de communication et de réseaux sociaux et l’utilisation d’algorithmes à l’intérieur de ces dispositifs changent complètement la donne !

Face à ce changement radical qui transforme notre relation cognitive au monde, Michel Wieviorka dans son manifeste l’Impératif numérique [analyse de Jean-François Blanchard] exhorte les chercheurs « à ne pas abandonner le domaine à des spécialistes et à prendre la mesure des enjeux qui sont vitaux pour les SHS. Utiliser les ressources numériques, intégrer le numérique dans les méthodes de travail et les objets d’étude constituerait une première avancée vers une appropriation du changement ».

Manifeste des Digital Humanities/par Marin Dacos. – THATCAMP Paris, 2010 maj. 25/01/12. – Hypothèse.org

Berra, Aurélien. – Faire des humanités numériques. – in Read/Write 2/Pierre Mounier, dir. – Open Edition Books, p.25-43. – 2012

Plantin, Jean-Christophe ; Monnoyer-Smith. – Ouvrir la boite à outils de la recherche numérique. – Tic&Société vol.7:n°2, 2e semestre 2013

Blanchard, Jean-François. – Michel Wieviorka, l’impératif numérique ou la nouvelle ère des sciences humaines et sociales ? - Lectures Revues.org. – comptes-rendus 2013

Barret, Elydia. – Quel rôle pour les bibliothèques dans les humanités numériques ? Mémoire d’étude – ENSSIB -Université de Lyon, janvier 2014

Dacos, Marin ; Mounier, Pierre. – Rapport Humanités numériques. – Institut français ; Open Édition, 20/06/14 via Slideshare.net

Humanités numériques. – Institut français, 2014. – Publication d’une étude consacrée aux humanités numériques, soutien à la participation de chercheurs français à la conférence Digital Humanities 2014 de Lausanne, table ronde au Salon du livre, rencontres et débats dans le réseau culturel.

Humanités et cultures numériques : éléments d’histoire et de prospective/Milad Douehi ; Louise Merzeau. – DHNord 2014 Humanisme et humanités numériques. – Publie.meshs, 27/05/14

Dunleavy, Patrick. – Big data and the future of social sciences. – LSE podcasts – Audible impact episode 3, 06/08/14

Moatti, Alexandre. – Quelle acceptation du terme « humanités numériques ». – Bibnum, 19/11/14

Levy, Pierre. – My talk at « The Future of Text 2014. Communication presented at The Future of Text symposium IV at the Google’s headquarters in London (2014). – Pierre Levy’s Blog, 02/11/14

Quels agencements pour les humanités numériques ?/ Eddie Soulier.dir – Les Cahiers du numérique. – Numéro spécial, vol.10 – 2014/4. – via Cairn.info

Cavalié, Etienne. – Projet de mode d’emploi des humanités numériques. – Bibliothèques (reloaded), 30/01/15

Qu’est-ce que les humanités numériques ? - France Culture Plus, 25/05/15 [Alexandre Gefen (fabula.org), Pierre Mounier (CLEO), Michel Wieviorka (FMSH). Rencontre animée par Xavier de La Porte (France Culture) au Salon du Livre, Paris 2014).