Qui a peur de la 5G ? Débats et controverses sur la dernière génération de téléphonie mobile

Le 1er octobre, le gouvernement a récolté 2,786 milliards d’euros suite aux enchères autorisant le déploiement sur le territoire français de la technologie de 5e génération de téléphonie mobile. Que représente cette technologie ? Est-elle réellement disruptive ? Que va-t-elle changer dans nos usages ? A voir s’enflammer les débats autour de son adoption, on croit assister à une véritable guerre des anciens contre les modernes …

Le 1er octobre, le gouvernement a récolté 2,786 milliards d’euros suite aux enchères autorisant le déploiement sur le territoire français de la technologie de 5e génération de téléphonie mobile. Que représente cette technologie ? Est-elle réellement disruptive ? Que va-t-elle changer dans nos usages ? A voir s’enflammer les débats autour de son adoption, on croit assister à une véritable guerre des anciens contre les modernes …

A cela s’ajoutent des enjeux géopolitiques et géoéconomiques, la Chine dominant pour le moment le marché mondial de la 5G et les Etats-Unis n’ayant pas encore déployé cette technologie comme l’explique Evgeny Morosov dans le Monde Diplomatique. L’Europe a ainsi une opportunité de participer avec ses deux constructeurs Ericsson et Nokia … Comme le dit Philippe Escande dans son éditorial du Monde « Il est temps que s’ouvre enfin une réflexion apaisée et argumentée, aussi bien sur ses avantages que sur ses inconvénients ». Début septembre, 70 élus de gauche et écologistes demandaient un moratoire sur le déploiement de cette technologie, en accord avec les préconisations de la Convention citoyenne pour le climat. « Ces élus proposent une suspension du déploiement de la technologie « au moins jusqu’à l’été 2021 », ainsi que la « tenue d’un débat démocratique décentralisé sur la 5G et sur les usages numériques », la priorité serait pour eux plutôt la réduction de la ‘fracture numérique’ « à travers le développement de la fibre en zone rurale et en finalisant le déploiement de la 4G ». (Le Parisien). Les élus insistaient sur le fait que cette technologie augmenterait la consommation électrique et comporterait des risques en matière de santé.

La technologie 5G

« En télécommunications, la 5G est la cinquième génération des standards pour la téléphonie mobile. Succédant à la quatrième génération, appelée 4G, elle prolonge l’exploitation technologique LTE (Long Term Evolution : norme de réseau de téléphonie mobile 4G)

La technologie 5G donnera accès à des débits dépassant de 2 ordres de grandeur la 4G, avec des temps de latence (délais de transmission dans les communications informatiques) très courts et une haute fiabilité, tout en augmentant le nombre de connexions simultanées par surface couverte. Elle vise à supporter jusqu’à un million de mobiles au kilomètre carré (dix fois plus que la 4G). Une fois déployée, elle doit permettre des débits de télécommunications mobiles de plusieurs gigabits de données par seconde, soit jusqu’à 1 000 fois plus que les réseaux mobiles employés en 2010 jusqu’à 100 fois plus rapides que la 4G initiale » (Wikipedia)

Les avantages de la 5G

Accélération de la transmission des données et temps de latence raccourcis : 10 à 100 fois plus rapide que la 4G. Mais comme le fait remarquer Xavier Lagrange dans l’article de The Conversation, « Il ne s’agit pas d’une rupture technologique majeure, mais plutôt d’améliorations […] la technologie repose sur les mêmes principes que la 4G, c’est la même forme d’onde qui sera utilisée, le même principe de transmission ».

Accélération de la transmission des données et temps de latence raccourcis : 10 à 100 fois plus rapide que la 4G. Mais comme le fait remarquer Xavier Lagrange dans l’article de The Conversation, « Il ne s’agit pas d’une rupture technologique majeure, mais plutôt d’améliorations […] la technologie repose sur les mêmes principes que la 4G, c’est la même forme d’onde qui sera utilisée, le même principe de transmission ».

« A-t-on besoin d’aller plus vite ? Pour certaines applications, dans certains champs professionnels, oui. Pour d’autres, … bien au contraire. » remarque Olivier Ertzschied dans son post d’Affordance.info

- Baisse de la consommation d’énergie : « La 5G permet une meilleure gestion des faisceaux de communication avec deux avantages immédiats : une baisse de la consommation énergétique car la dispersion des ondes radio est limitée ; une amélioration de la qualité d’utilisation des ondes radio, puisque les interférences sont évitées » (Parti Pirate). Mais la baisse de la consommation énergétique peut mener à une augmentation des échanges de communications, donc à consommer plus … Comme le soutient Jean Soubiron, dans sa tribune sur Libération « Dans les faits, les technologies plus efficientes permettent à l’économie de produire davantage, entraînant inévitablement un accroissement des consommations de matières et d’énergie. » De plus, « L’utilisation de nouvelles fréquences ne peut, que conduire à la consommation électrique des opérateurs » (The Conversation).

- Un réseau plus flexible : le réseau déployé sera configurable. A terme, il fera beaucoup plus appel à des technologies informatiques de virtualisation. « L’opérateur pourra faire démarrer des machines virtuelles pour, par exemple, s’adapter à une demande accrue d’utilisateurs dans certaines zones ou à certains moments et au contraire ; diminuer les capacités si peu de personnes sont présentes » (The Conversation).

- Diminution des coûts : Plutôt pour les opérateurs que pour les consommateurs.

- De nouvelles applications : Avec la 5G, on va connaître l’expansion de l’Internet des objets (IOT : Internet Of Things) avec la voiture autonome et la « ville connectée » (Smart city). Elle encouragera aussi le développement de la télé-médecine et l’automatisation de l’industrie « Pour les industriels, nous pouvons penser aux usines connectées et automatisées dans lesquelles un grand nombre de machines devront pouvoir communiquer entre elles et avec le réseau global ». Pour les consommateurs, l’augmentation de la vitesse du réseau permettra le téléchargement plus rapide de toutes sortes de fichiers (vidéos en direct ou en streaming, jeux vidéo, etc.).

Ces nouvelles fonctionnalités s’adressent en fait plus à l’industrie et aux services plus qu’au grand public. Là encore, Olivier Ertzschied, pose la question « Le déploiement de cet internet des objets est-il nécessaire et utile à la société et aux individus qui la composent ? » Si l’on considère par exemple le cas des voitures connectées, « si le risque est présent, ce n’est pas parce que les choses (programmes, algorithmes, capteurs) vont trop lentement, c’est justement parce qu’ils vont (déjà) trop vite dans leurs boucle de rétroaction […] un accident de la route impliquant une voiture autonome peut également advenir et n’être pas évitable ou évité, soit du fait de la vitesse de l’échange des informations et données nécessaires à la prise de décision, soit du fait de la décorrélation entre la vitesse de prise de décision des véhicules ‘autonomes’ et celle des véhicules ‘non-autonomes ».

Les risques pour l’environnement et la santé

Depuis le début de l’année, des associations alertent les pouvoirs publics sur les risques de cette technologie pour la santé et l’environnement. Agir pour la santé et PRIARTEM ont déposé plusieurs recours devant le Conseil d’Etat visant à geler le déploiement de la 5G. Ces associations ont souligné les incertitudes qui accompagnent les émissions d’ondes et demandent l’application du principe de précaution. « On sait que ces ondes ont un impact sur notre cerveau, que des personnes manifestent des troubles d’électro-sensibilité » a déclaré Sophie Pelletier de PRIARTEM, cité par Pierre Manière dans La Tribune. A cela s’ajoutent des risques de cancérogénicité.

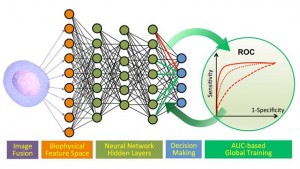

L’Agence nationale de sécurité sanitaire (ANSES) ne se prononce pas en raison du manque de données scientifiques sur les effets sur la santé de certaines fréquences d’ondes électromagnétiques utilisées pour la 5G. Cela concerne surtout la bande de fréquences de 3,5 GHz qui doit être attribuée aux opérateurs. L’ANSES a davantage de données sur les fréquences de 26 GHz, dites ‘millimétriques’ qui seront attribuées plus tard. C’est aussi ce que répondent les Décodeurs du Monde dans leur rubrique de questions sur la 5G. Aucun effet significatif des ondes sur la santé n’a été observé. Les antennes 5G, peu nombreuses au début, n’émettront leur signal que quand elles seront sollicitées par un terminal ; les antennes 4G le font en permanence …

Pour le spécialiste Olivier Merkel, il n’y a pas de « réponse tranchée » ; la source la plus préoccupante pour la santé est plutôt le téléphone portable en contact avec le corps. On n’a pas plus de résultats sur l’effet cancérigène : il n’y a pas de lien concret entre l’exposition aux ondes et un cancer. On constate un ADN endommagé sur certains animaux, mais on ne peut rien en déduire. Le rapport de l’ANSES sur la 5G est prévu pour début 2021.

Environnement et consommation numérique

Comme on l’a vu plus haut, la 5G est beaucoup moins énergivore que la 4G, mais la facture énergétique dépendra beaucoup des usages qui ont tendance à se multiplier, c’est ce qu’on appelle l’’effet rebond’. « La hausse considérable de la demande de données pourrait contrebalancer les gains d’efficacité énergétique ».

La 5G va aussi entrainer un renouvellement des téléphones mobiles : déjà existante pour les précédentes technologies, l’’obsolescence programmée’ va encore s’imposer. Certains modèles vendus aujourd’hui sont déjà compatibles avec cette nouvelle norme !

Comme le constate le Parti Pirate dans son post « Le renouvellement du parc mobile nécessite effectivement une quantité importante de ressources, notamment de terres rares, et va nous contraindre à produire une certaine quantité de gaz à effet de serre. Ici encore, cela n’est pas inhérent à la 5G, mais plutôt aux choix politiques et économiques que nous faisons. ». Contre l’effet rebond qui permettra à l’utilisateur moyen, d’après Ericsson, de consommer 200 GO de données en 2025, contre 6,5 GO actuellement, Paul Camicas et Stephen Demange de La Tribune, prônent la ‘sobriété numérique’ « Le débat qui s’ouvre ne doit pas nous amener à repousser purement et simplement la 5G, mais plutôt à interroger notre rapport au numérique et à trouver les moyens d’optimiser la consommation de données, pour viser collectivement la sobriété numérique. ».

E-sécurité : espionnage et surveillance

La 5G représente un saut vers l’hyperconnectivité et risque de poser un problème dans la récolte des données comme le fait remarquer Sébstien Soriano, Président de l’ARCEP. Il y a des risques d’espionnage par des entreprises étrangères, d’où les restrictions des opérateurs français vis-à-vis de Huawei. Bouygues Telecom a promis de démonter toutes les antennes du constructeur chinois installées dans les zones peuplées !

Mais, paradoxalement, les services secrets craignent que la 5G les empêchent d’espionner en toute sécurité ! Comme l’indique Emmanuel Paquette dans l’Express « Dans la plus grande discrétion, les agents secrets ont fait part de leurs craintes auprès de certains élus : ils redoutent en effet qu’elle rende inopérant un matériel de surveillance indispensable, appelé Imsi-catcher. ». Ils ne pourraient plus ainsi géolocaliser et capter les informations circulant sur le réseau …

Mais comme le fait remarquer Stéphane Bortzmeyer dans son post « beaucoup d’arguments entendus contre la 5G n’ont en fait rien de spécifique à la 5G : les risques pour la vie privée ne changent pas […] les caméras de surveillance existent déjà sans avoir besoin de la 5G, les objets connectés qui envoient massivement à leur fabricant des données personnelles sur les utilisateurs, existent également depuis un certain temps, la 5G ne va pas les multiplier. […] Mais peut-être un changement quantitatif (performances supérieures, même si elles ne le seront pas autant que ce que raconte le marketing) va-t-il déclencher un changement qualitatif en rendant trivial et/ou facile ce qui était difficile avant ? Peut-être. »

C’est aussi ce que craint Olivier Ertzschied « Littéralement autant que métaphoriquement la 5G est une « accélération propre » qui provoquera nécessairement des contraintes et des déformations non pas seulement sur des objets techniques mais sur l’ensemble du corps social et l’organisation politique de nos communautés. ».

Bortzmeyer souligne aussi une implication importante de la 5G, qui n’a pratiquement pas été soulevée dans le débat : « le ‘network slicing’ qui permet d’offrir plusieurs réseaux virtuels sur un accès physique. […] Ses conséquences peuvent être sérieuses, notamment parce qu’il peut faciliter des violations de la neutralité de l’Internet, avec une offre de base, vraiment minimale, et des offres « améliorées » mais plus chères. ». Donc, un internet à plusieurs vitesses …

La controverse sur le progrès : ‘Amish’ vs ‘Start-up nation’

Les enchères de la 5G ont provoqué une polémique où l’on a vu les tenants du ‘progrès’, avec à leur tête le Président de la République, s’opposer aux défenseurs de l’environnement et des libertés publiques !

Devons-nous soutenir toute nouvelle technologie, quel qu’en soit le prix comme le dénonce Bruno Latour dans sa tribune au Monde ? « Le train du progrès a-t-il des aiguillages ? Apparemment, pour notre président, il s’agit d’une voie unique. Si vous n’allez pas tout droit, vous ne pouvez que « revenir en arrière », ce qui veut dire « régresser », et, comme il l’a récemment affirmé, s’éclairer à « la lampe à huile » [il réagissait à la demande de moratoire sur le déploiement de la 5G de 70 élus de gauche et écologistes]. Que cet argument soit encore considéré comme imparable, au moment même où le monde brûle parce que le « train du progrès » nous a menés au désastre, a quelque chose de désespérant. ».

C’est aussi ce qu’exprime l’architecte Jean Soubiron dans Libération en dénonçant le ‘solutionnisme’ du gouvernement : « D’un côté, le gouvernement voit en cette «innovation» la promesse d’une gouvernance plus efficace de nos flux de matières quand, de l’autre, il n’a pas jugé utile de mesurer le risque que font peser ces nouvelles technologies sur nos ressources et nos écosystèmes ».

Alors que pour certains, « La 5G est la clé de l’industrie 4.0 » et permettra de sortir de la crise comme le préconise John Harris dans sa tribune de Forbes France « Aussi nombreux que variés, ils bénéficieront à un vaste éventail de secteurs. L’usine intelligente et la production constituent deux gagnants évidents de la nette amélioration de l’automation et des efficacités due à la connectivité de l’IoT. […] Tout laisse à penser que le déploiement de réseaux 5G à travers l’Europe présage de formidables opportunités pour le monde professionnel. ».

Mais les positions ne sont pas toutes aussi tranchées, à commencer par celle de Sébastien Soriano, président de l’ARCEP, qui précise dans son interview dans Reporterre « Mais une chose est sûre, et c’est une ambition que nous partageons avec beaucoup de critiques de la 5G, pour nous prémunir de tous les méfaits que la technologie peut convoquer, nous devons en reprendre le contrôle. Non pas à travers un retour de balancier qui rendrait aux États la supervision des communications. Mais par un contrôle citoyen ».

Ce contrôle citoyen passe aussi par un débat qui représente un des enjeux du moratoire réclamé par les élus de gauche et EELV. Comme le rappelle Philippe Escande dans le Monde « Il est au contraire légitime de s’interroger sur l’impact économique, écologique et sécuritaire de la 5G. Dans un contexte de défiance grandissante des citoyens envers les institutions scientifiques et politiques, il est inimaginable de pouvoir faire l’impasse sur ce débat. Le degré d’acceptation de la technologie, le contrôle de ses applications et l’efficacité de son utilisation en dépendent. ».

Un débat, c’est ce réclame aussi le Parti Pirate, tout en avançant des propositions concrètes pour répondre aussi bien à l’obsolescence programmée qu’à la multiplication et à l’accélération des usages « Ce que nous devons craindre, c’est notre société qui nous pousse à consommer toujours plus, toujours plus d’objets connectés, toujours plus de gadgets à la mode, toujours plus de tout. […] Autrement dit, ces débats sont légitimes en tant que tels, et ce n’est qu’en les considérant en tant que tels que nous serons en mesure d’y répondre, plutôt qu’en nous opposant, par principe, à la 5G. ».

La conclusion d’Olivier Ertzschied va dans le même sens « Déployons la 5G si nous sommes capables d’organiser ce déploiement en contrepoint d’une réorganisation massive de notre rapport à la vitesse, à la latence, et à la connectivité. Déployons si nous sommes capables de ralentir quand il n’est pas nécessaire d’accélérer autrement que par la potentialité qui rend l’accélération possible. […] Déployons la 5G si nous sommes capables à tout moment d’en limiter à la fois l’échelle, le cadre et l’envie.

Maurice, Stéphanie. – Martine Aubry contre la 5G : conviction politique ou « greenwashing » anti-Macron ? – Libération, 11/10/20

Landeau-Barreau, Pauline. – 5G : la mairie de Paris veut consulter les citoyens avant le déploiement. – CNews, 05/10/20 MAJ 11/10

Usul ; Lietchi, Rémi. – 5G : un débit en débat. – Médiapart, 05/10/20

Paquette, Emmanuel. – Les espions aussi s’inquiètent de la 5G. – L’Express, 04/10/20

Pétillon, Catherine. – 5G : des émissions pour comprendre ce qui fait débat. – France Culture, 04/10/20

Fagot, Vincent. – Enchères 5G en France : l’Etat récolte récolte près de 3 milliards d’euros. – Le Monde, 02/10/20

5G : définition, fonctionnement, usages et déploiement du réseau en France, tout ce qu’il faut savoir. – CNET France, 02/10/20

Morozov, Evgeny. – Bataille géopolitique autour de la 5G. – Le Monde diplomatique, Octobre 2020

Questions-réponses : Six questions sur le lancement de la 5G. – Vie publique, 01/10/20

La question de la 5G mérite-t-elle autant de passions ? - Blog Stéphane Bortzmeyer, 01/10/20

Millon, Louise. – La Chine dépasse les 100 millions d’abonnés 5G … et la technologie consomme beaucoup. – Presse-citron, 01/10/20

Escande, Philippe. – 5G : un débat qui reste à mener. – Le Monde, MAJ 30/09/20

Equy, Laure ; Belaïch, Charlotte. – Le progrès, casse-tête de la gauche. – Libération, 28/09/20

Foucart, Stéphane. – Débat sur la 5G : « Des Amish aux Shadoks ». – Le Monde, MAJ 27/09/20

Souviron, Jean. – 5G : Sortir d’un débat caricatural entre technophobes et technophiles. – Libération, 26/09/20

La 5G, qu’est-ce que c’est ? Comment ça marche ? – The Conversation, 25/09/20

Damgé, Mathilde. – Sur la 5G, ce qui est vrai, ce qui est faux et ce que l’on ne sait pas encore. – Le Monde, 24/09/20

Latour, Bruno. - « Si le déconfinement a eu un effet, c’est de nous déconfiner de cette idée d’une voie unique vers le progrès ». – Le Monde, 24/09/20

Tesquet, Olivier. – Avec la 5G, la France au bord de l’excès de vitesse. – Télérama, 22/09/20

Tableaux de bord des expérimentations 5G en France. – ARCEP, 22/09/20

Charles, Frédéric. – 5G en France : obstacle à mi-chemin. – ZDNet, 22/09/20

Ertzscheid, Olivier. – La 5 (re)G : nous sommes tous des enfants connectés. – Affordance.info, 21/09/20

5G : Elevons le débat. – Parti pirate, 21/09/20

Téléphonie mobile : 70 élus de gauche demandent un moratoire sur la 5G. – Le Parisien, 13/09/20

Camicas, Paul ; Demange, Stephen. – 5G, l’arbre qui cache la forêt. – La Tribune, 18/08/20

Popovski, Petar ; Björnson, Emil ; Boccardi, Federico. – Communication technology through the new decade. – IEEE ComSoc Young Professionals, 18/08/20

Soriano, Sébastien (Arcep). – « Favorables à la 5G, nous souhaitons tout de même un contrôle citoyen ». – Reporterre, 12/06/20

Harris, John. – La 5G sera-t-elle la clé de l’industrie 4.0 ? - Forbes France, 13/03/20