Défiance du public, concurrence des réseaux sociaux et fin du modèle économique : quel avenir pour le journalisme ?

Alors qu’en France les médias sont attaqués de toutes part, aussi bien par les partis extrêmes et le mouvement des « Gilets Jaunes » que par le Président de la République sans parler du scandale de la « Ligue du LOL », au Royaume Uni, un rapport commandé par le gouvernement, s’inquiète de l’avenir de ce secteur et préconise un certain nombre de mesures « pour un futur durable du journalisme ».

Alors qu’en France les médias sont attaqués de toutes part, aussi bien par les partis extrêmes et le mouvement des « Gilets Jaunes » que par le Président de la République sans parler du scandale de la « Ligue du LOL », au Royaume Uni, un rapport commandé par le gouvernement, s’inquiète de l’avenir de ce secteur et préconise un certain nombre de mesures « pour un futur durable du journalisme ».

Si elle se révèle aujourd’hui de façon criante, la crise de cette profession existe depuis plusieurs années. En 2004, nous avions réalisé à la Bibliothèque de Sciences Po un dossier documentaire sur ce sujet, présentant déjà des préoccupations semblables : éthique et déontologie, émergence de nouveaux médias, fragilisation du modèle économique. « Manipulateur-manipulé, le journaliste dispose-t-il encore du pouvoir dont on le crédite ? Participe-t-il à cette fabrique de l’opinion où tous les sujets sont passés au tamis du système médiatique ? […] Comme dans d’autres secteurs, celui des médias subit une restructuration qui fragilise l’emploi et se traduit par une précarisation de la profession. L’évolution technologique touche au cœur même du métier ».

L’impact de l’internet et la fin du modèle économique des médias traditionnels

Le rapport Cairncross, du nom de la journaliste chercheure chargée de sa réalisation, souligne l’impact de l’arrivée d’internet sur le modèle économique de la presse en Grande-Bretagne : « Avec la baisse drastique des revenus publicitaires sur format papier, elle a encore du mal à compenser les pertes sur le numérique. Les revenus publicitaires étant principalement captés par les géants du web, elle a dû faire des économies. C’est-à-dire au détriment des investissements qu’elle aurait pu faire pour accompagner sa transformation digitale ou encore en rognant sur les coûts de l’information (- 6000 journalistes depuis 2007 au Royaume Uni). » (Alexandre Bouniol dans Meta-Media). Les deux types de journalisme les plus touchés sont le journalisme d’investigation (trop cher) et la presse locale. On constate une contraction des contenus locaux, donc une baisse d’implication dans la vie politique et sociétale … L ’arrivée du smartphone s’accompagne d’une baisse drastique de la distribution des quotidiens nationaux qui passent de 11, 5 millions d’exemplaires en 2008 à 5,9 millions en 2018. Le nombre de quotidiens locaux passe de 1303 à 982 entre 2007 et 2017.

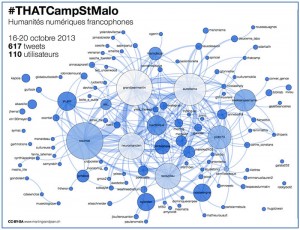

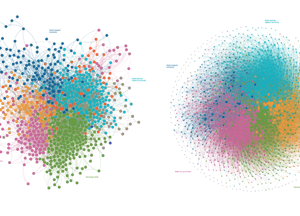

L’émergence des ‘pure players’ comme Buzzfeed ou le Huffpost de même que le passage par des plateformes d’information comme Google News, Apple News et Facebook, changent complètement le comportement des lecteurs pour accéder à l’information. En passant par ces plateformes, le lecteur n’a plus accès à un ‘panorama’ de l’information comme dans un journal. L’accès se fait article par article suivant un algorithme construit à partir des données de l’utilisateur. « Les informations d’intérêt public sont celles qui émergent le moins sur les plateformes. Les algorithmes ne sélectionnent pas la pertinence d’un contenu mais récompensent les contenus qui se partagent le plus. ». Cette ‘désagrégation de l’information’ « fait que les adultes britanniques passent de moins en moins de temps à s’informer et se sentent submergés par le flot de l’information ».

En France aussi, la presse et les médias traditionnels intéressent de moins en moins le grand public. Le dernier Baromêtre de la Croix le confirme. Dans cette enquête, les Français montrent une vraie défiance envers les médias. La télévision recule de 10 points (38%), la radio de 6 points (50%) et la presse écrite de 8 points (44%%). Quant à internet, il est jugé fiable par 25% des sondés… Comme le souligne Thierry Wojciak de Cbnews, « l’étude met au jour un paradoxe « les médias auxquels les Français accordent le moins de confiance sont ceux qu’ils utilisent le plus pour s’informer. » La télévision reste en tête (46% des sondés) devant internet (29%). Mais ce qui est inquiétant c’est que moins de la moitié des jeunes 18-24 ans prêtent intérêt aux nouvelles, alors que près des trois quarts des plus de 65 ans (74%) s’y intéressent encore. L’enquête a aussi étudié la perception du traitement médiatique du mouvement des Gilets jaunes. Moins d’un tiers du panel (32%) se disent satisfaits de la couverture médiatique du mouvement, alors que 51% la jugent mauvaise. Il leur est reproche d’avoir « dramatisé les évènements » (67%), trop laissé s’exprimer un point de vue extrême (52%), ne pas avoir permis de « bien comprendre » (54%). La violence envers les journalistes est justifiée pour 23% des personnes interrogés, tandis que 32% la condamnent et 39% ne la jugent pas « vraiment justifiée ».

Par ailleurs, pour nombre de « Gilets jaunes », seuls deux médias, en dehors de leurs cercles sur les réseaux sociaux, ont grâce à leur yeux, RT, la chaîne d’information d’influence russe, et Brut, une chaine vidéo aux commentaires très ‘factuels’.

Lutte contre les infox et déontologie de l’information

Le rapport Cairncross dénonce aussi le manque de clarté pour distinguer les informations vérifiées des infox. Pour remédier à cela le rapport propose plusieurs solutions : rendre responsables juridiquement les plateformes, que la rapporteuse trouve elle-même assez délicat ; introduire dans l’algorithme un quota d’informations de bien public afin que tout le monde ait accès à ce genre de contenus ; mettre en place une instance de régulation qui rendrait compte de la qualité d’information diffusée sur ces plateformes.

On retrouve cette préoccupation en France, où le Président Macron voudrait introduire un contrôle des médias, comme le rapporte Claude Askolovitch dans Slate. Le Président voudrait « s’assurer de la neutralité et vérifier l’information dans les médias, en créant des structures financées par l’Etat qui contrôleraient médias publics et privés, structures nantis de journalistes qui seraient les ‘garants’ de l’affaire ». Claude Askolovitch continue en ironisant « Notre Président veut mettre le journalisme sous tutelle, telle une classe sociale assistée […] La liberté s’épanouira sous la contrainte ? Son organe de vérification s’imposera-t-il à la presse ? Les journalistes qui lui seront affrétés deviendront-ils nos supérieurs et nos gardiens, nos censeurs, les auxiliaires du pouvoir, de l’Etat ? ». Cela risque, comme pour la loi sur les Fake news, de remettre en cause de la liberté d’expression en introduisant une dose de censure et surtout se pose la question « qui va contrôler les contrôleurs ? ».

Plus concrètement, des syndicats de journalistes ainsi que d’autres instances de l’édition, notamment l’Observatoire de la déontologie de l’information préconisent la création d’un Conseil de presse. Ce projet, qui réunirait aussi bien des journalistes, des éditeurs et des représentants du public, aurait comme objectif de gérer et instruire les plaintes mais aussi de proposer des orientations en matière de déontologie. Il pourrait s’appuyer sur le rapport, « Autorégulation de l’information : comment incarner la déontologie ? », réalisé en 2014 par Marie Sirinelli et le Ministère de la Culture. Cette idée est encore controversée dans le milieu journalistique et les médias, mais est soutenu par une personnalité comme Jean-Luc Mélenchon qui déplore qu’on ne dispose que de la justice pour « faire appliquer une sanction pour dissuader de recommencer ».

Or, ce sont souvent les rédactions qui s’opposent à la mise en œuvre d’une telle instance, c’est ce que soulignent les intervenants de l’émission « Faut-il noter les journalistes ? » (Du grain à moudre – France Culture) alors que souvent il existe déjà une charte déontologique dans les organes de presse (Les Echos, Radio France). « C’est à chaque rédaction de prendre son destin en main […] il faut que tous les rédacteurs soient capables de se défendre des pressions des actionnaires » soutient François Ernenwein, rédacteur en chef de La Croix, « Il faut donner aux rédactions les moyens de se défendre contre certaines pressions (loi Bloche, Secret des affaires) pour Leila de Cormamond, journaliste sociale aux Echos

Regagner la confiance du public et construire un journalisme de qualité

Regagner la confiance du public et construire un journalisme de qualité

La crise des Gilets jaunes a révélé en France la défiance d’une importante partie du public vis-à-vis des médias et des journalistes. Certains se sont lancé dans une autocritique de leurs pratiques comme les rédacteurs réunis dans le dossier de Libération. Dans ce dossier, les journalistes se soumettent à un « examen de confiance ». Les 25 professionnels de l’information se demandent « s’ils ne méritent pas une partie de la méfiance qu’ils inspirent et que la terrible pression qui plombe le secteur des médias et contraint la bonne pratique du métier, ne sert pas d’argument refuge à tous les reproches ». Les journalistes ont conscience de leur uniformité sociale et culturelle, et que, hormis les pigistes et les CDD, il font plutôt partie de la couche moyenne-supérieure de la société (la fameuse ‘élite’ intellectuelle, honnie par le ‘peuple’). Cet ‘entre-soi’ pourrait aussi expliquer le succès de groupes comme la Ligue du LOL, où de brillants journalistes (blancs, males et très parisiens) harcèlent leurs consœurs sur les réseaux sociaux. Les journalistes reconnaissent qu’ils ne ‘s’adressent pas à la masse des gens’. Comme l’exprime Jean-Emmanuel Decoin, rédacteur en chef de l’Humanité «La presse écrite ne raconte pas la vraie vie des gens et on le prend en pleine gueule aujourd’hui. […] Où raconte-t-on la souffrance, la vie derrière les murs des entreprises ? ». De plus, la majorité des journalistes résident dans la région parisienne (20 000 des 35 000 cartes de presse). « Hors de Paris, la presse nationale se donne de moins en moins les moyens d’enquêter. dit Sylvain Morvan, de Médiacités. La presse régionale aussi ferme des antennes locales. Des villes petites et moyennes deviennent des déserts médiatiques. L’actualité locale est moins bien traitée, les journaux perdent en qualité. Il est probable que cela joue sur la défiance ».

Expliquer comment on travaille et on débat comme le suggère Amaelle Guitton de Libération, c’est aussi l’objectif de Pierre Ganz de l’ODI. « Beaucoup de gens ne savent pas comment on fabrique l’information. Les choix éditoriaux sont libres et différents de problèmes de déontologie. ». Car s’il existe un besoin de représentation et d’explication dans le public, il existe aussi un besoin d’interpellation. « Le désir de noter les journalistes vient de personnes qui estiment que les journalistes traitent trop peu souvent de leurs vies, de leurs combats. Il a fallu que les Gilets jaunes descendent dans la rue pour qu’on parle d’eux. Il faudrait pas laisser le soufflé tomber » souligne Pierre Ganz. Le public identifie l’ensemble des journalistes à quelques personnalités : il faut diversifier la formation des journalistes et par exemple développer le journalisme scientifique comme le préconise Olivier Dessibourg dans Meta-média. « Beaucoup de journalistes considèrent que leur rôle est de dire le bien et le mal, comment il faut penser » remarque Natacha Polony, directrice de Marianne. C’est aussi l’avis de Brice Couturier, chroniqueur à France Culture « Avant, nous avions le monopole de l’information. Désormais, l’information nous devance sur les réseaux sociaux. Nous avons réagi en idéologisant à mort, en devenant des directeurs de conscience. Mais en réalité, un journaliste a peu de compétences, il est généraliste, car on n’approfondit pas les sujets en école de journalisme ».

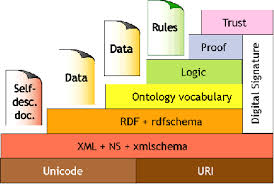

Une des nouvelles pistes possibles est le ‘journalisme de données’. L’analyse qualitative de données est encore peu courante dans le journalisme, comme le constate Bruno Breton dans Les Échos. A l’exception de quelques initiatives pionnières comme « les Panama Papers ou les Paradise Papers à l’occasion desquelles l’ICIJ (consortium international des journalistes d’investigation) a agrégé des millions de données pour épingler certains paradis fiscaux, la presse reste frileuse. ». L’utilisation des données publiques, issues par exemple, des réseaux sociaux pourrait être un atout éditorial puissant dans le travail des journalistes, surtout si elles ont été traitées avec des outils adéquats. Cet argument est aussi avancé dans l’émission Soft Power de Frédéric Martel sur France Culture. « Avec la généralisation d’internet, l’accumulation exponentielle des données et la puissance inédite des réseaux sociaux, on assiste à une démultiplication des sources numériques disponibles. Les journalistes s’en emparent : ce sont de nouveaux outils de recherche ; de nouveaux terrains d’enquêtes ; de nouveaux types d’enquêtes et d’écritures. »

« Il faut en revenir aux faits » comme le soutien Géraldine Mulhmann dans une interview sur Rue89 « Il ne s’agit pas d’invoquer un idéal d’’objectivité’ sans précaution ni doutes.[…] Il s’agit juste de dire que le ‘je’ d’un reporter entre en compte d’une manière toute à fait différente, dans son reportage, que le ‘je’ d’un éditorialiste ». Cela ne signifie par autre chose que l’impératif pour le journalisme, de « faire du journalisme et de le faire bien ». Retrouver le rapport tangible aux faits au lieu de se contenter d’un rapport souvent ‘virtuel’. « Il est important que le public comprenne qu’il y a une différence entre un lieu de pure expression ou d’opinion et un lieu qui veut donner de l’information. […] Faire voir à quel point il y a un monde entre une rumeur même très puissante sur internet et une enquête minutieuse et soigneusement racontée ».

On retrouve ce manque d’analyse sérieuse dans les menées de la « Ligue du Lol ». Comme le souligne la linguiste Laélia Véron dans la table-ronde d’Arrêt sur images « Ces gens qui sont censés maîtriser la langue ne les ont jamais attaqués sur le fond. Il n’y a jamais eu de débat d’idées ».

Les journalistes pourraient aussi s’inspirer du succès de Rémy Busine, le créateur de Brut, très populaire auprès des  Gilets jaunes, comme le fait remarquer Nicolas Bequet du quotidien Belge l’Echo « Proximité, écoute, humilité et simplicité, voilà ce qui caractérise son attitude face aux manifestants. L’exercice du ‘live’ façon Brut est une forme de retour aux sources, une interprétation des nombreuses missions dévolues aux journalistes : regarder, s’étonner et restituer. Le tout à hauteur d’homme. Une approche à l’antithèse de la perception qu’ont les classes populaires des médias dits traditionnels ».

Gilets jaunes, comme le fait remarquer Nicolas Bequet du quotidien Belge l’Echo « Proximité, écoute, humilité et simplicité, voilà ce qui caractérise son attitude face aux manifestants. L’exercice du ‘live’ façon Brut est une forme de retour aux sources, une interprétation des nombreuses missions dévolues aux journalistes : regarder, s’étonner et restituer. Le tout à hauteur d’homme. Une approche à l’antithèse de la perception qu’ont les classes populaires des médias dits traditionnels ».

Nouveau terrains, nouvelles pratiques pour le journalisme. – Soft Power – France Culture, 03/03/19

Faut-il noter les journalistes ? – Du grain à moudre- France Culture, 28/02/18

Bouniol, Alexandre. – Les principales leçons du rapport britannique sur l’avenir du journalisme. – Méta-Média, 22/02/19

Doctor, Ken. - The New York Times’Mark Thompson on how he’d run a local newspaper: « Where can we stand and fight? – NiemanLab.org, 22/02/19

Ganz, Pierre. – Un débat citoyen sur les médias. – Observatoire de la Déontologie de l’Information, 20/02/19

« Il ne faut pas jeter le LOL avec l’eau du bain ». – Arrêt sur image, 15/02/19

The Caincross Review: a sustainable future for journalism/Department for Digital, Culture, Media & Sport. – Gov.UK, 12/02/19

Lamy, Corentin. – Journalistes, réseaux sociaux et harcèlement : comprendre l’affaire de la Ligue du LOL. – Le Monde, 10/02/19

Askolovitch, Claude. – Emmanuel Macron, le journalisme de cour et le contrôle des médias. – Slate, 03/02/19

Littau, Jeremy. – The Crisis Facing American Journalism did not start with the Internet. – Slate, 26/01/19

Carasco, Aude. – Baromètre médias, les journalistes sommés de se remettre en cause. – La Croix, ma 25/01/19

Ferney, Jeanne. – Actualité : entre jeunes et séniors, le grand écart. – La Croix, 24/01/19

Wojciak, Thierry. – La confiance des Français dans les médias: la TV, la radio et la presse écrite pointées. – CBNews, 23/01/19

Ce que pourrait être un Conseil de presse : les propositions de l’ODI. – Observatoire de la Déontologie de l’Information, 23/01/19

Autocritique des médias : l’examen de confiance. – Libération, 19/01/19

Lefilliâtre, Jérôme. – De la critique des médias à la passion de l’immédiat. – Libération, 04/01/19

Bellanger, Anthony. – Un projet controversé de Conseil de presse en France. – Le Monde diplomatique, décembre 2018

Cahier de tendance Automne-Hiver : bientôt l’ère des post-news ? – Meta-Media, 17/12/18

Dessibourg, Olivier. – Pourquoi il faut miser sur le journalisme scientifique. – Meta-Media, 17/12/18

Géraldine Mühlmann : « Revenir aux fondements du journalisme moderne ». – Rue89, 16/11/18

Breton, Bruno. – Le data journalisme, une chance pour la presse. – Les Échos, 24/05/18

Autorégulation de l’information : comment incarner la déontologie/Marie Sirinelli ; Ministère de la culture et de la communication. – Rapports publics – La Documentation française, février 2014

Quel avenir pour le journalisme ? Crise structurelle ou évolution de la profession. – Dossier documentaire. – Sciences Po – La Bibliothèque, Juin 2004