Quel avenir pour l’enseignement à distance ?

Émergeant il y a cinq ans, les MOOCs avaient soulevé un grand enthousiasme en matière d’enseignement en ligne : voir ces cours prestigieux d’universités d’élite mis à la disposition gratuitement du plus grand nombre représentait une ‘disruption’ dans l’univers sélectif de l’enseignement supérieur, en particulier aux États-Unis où l’accès à l’Université est difficile et les droits de scolarité élevés.

Émergeant il y a cinq ans, les MOOCs avaient soulevé un grand enthousiasme en matière d’enseignement en ligne : voir ces cours prestigieux d’universités d’élite mis à la disposition gratuitement du plus grand nombre représentait une ‘disruption’ dans l’univers sélectif de l’enseignement supérieur, en particulier aux États-Unis où l’accès à l’Université est difficile et les droits de scolarité élevés.

L’éclatement de la bulle Mooc

Les Moocs ont-ils fait ‘pcshitt’, comme le prétend Marine Miller dans son article du Monde ?

Un certain nombre de critiques s’élèvent contre l’évolution de cette innovation pédagogique. Tout d’abord, sa technologie qui n’a rien de vraiment révolutionnaire : des vidéos de cours magistraux accompagnés de quelques quizz … C’est loin d’être la disruption annoncée … De plus, la gratuité des cours, qui faisait l’attrait de ce dispositif, notamment dans les pays anglo-saxons, a été partiellement réduite, en particulier en ce qui concerne la certification ou les crédits dont les étudiants peuvent bénéficier. Sans parler de ceux qui déplorent la dématérialisation des cours et l’absence physique du professeur (et des étudiants !).

Malgré les 25 millions de participants et avec un marché estimé de 2500 millions de dollars (chiffres de 2015à vérifier), les MOOCs ne semblent pas avoir trouvé leur rythme de croisière. D’après une étude de Coursera, citée par Managexam, seuls 4% des étudiants avouent poursuivre leur formation jusqu’au bout … ! Et tous les étudiants n’ont pas la capacité d’apprendre de façon autonome … Mais tous les participants ne cherchent pas forcément à décrocher le diplôme ou la certification à mettre sur leur CV … Et près de 50% en ont suivi au moins la moitié … !

Mais plus sérieusement, c’est la philosophie même de ces cours en ligne qui est remise en cause. Outre les abandons massifs et le changement de modèle économique des plateformes, Karen Head dénonce le « colonialisme académique » que représentent les MOOCs dans son livre Disrupt This !, cité dans la recension de livres de Impact of Social Science. Professeur associée de littérature au Georgia Institute of Technology (Georgia Tech), elle a expérimenté elle-même ce dispositif en proposant son cours d’écriture de 1ere année sur un MOOC, bénéficiant d’un financement de la Gates Foundation qui voulait disposer au moins d’un cours non-traditionnel dans son offre. Ce ‘point de vue de l’intérieur’ lui a permis de nuancer son impression. Pour elle, cette disruption évolue dans le contexte du modèle éducatif de l’enseignement supérieur américain, la plupart des plateformes sont basées aux USA et nouent des partenariats avec les universités américaines les plus renommées. C’est difficile d’évoquer une ‘démocratisation’ de l’enseignement supérieur dans ce contexte. Les plateformes européennes (FUN, FutureLearn[GB]) ont plus ou moins imité le modèle américain. La seule proposition ‘vendable’ des Moocs, c’est la promesse d’un changement positif pour tout un chacun, que les ‘mal desservis du monde entier’ vont pouvoir profiter d’un accès libre aux enseignements des meilleures universités’. En fait, on assiste à l’adoption de contenu payant produit par ces grandes universités par les petites et moyennes universités, le développement et la maintenance d’un MOOC reste encore très opaque.

L’évolution du modèle économique : des MOOCs aux SPOCs

Ce que montrait aussi l’étude de Coursera, c’est la tendance à préférer les cours qui ont un aspect de formation professionnelle : 52% des interrogés suivent un cours pour améliorer leurs compétences dans le cadre de leur travail ou pour trouver un emploi. C’est cette ‘employabilité’ que critiquait d’ailleurs Karen Head, son cours de ‘composition de première année’ ne remplissait évidemment pas ce critère et ne pouvait pas être évalué de la même façon … Dans ce contexte professionnel, on retrouve l’influence des entreprises et l’importance du classement et des statuts des étudiants. C’est aussi cette variable qui a conduit des plateformes comme Coursera et Udacity à faire payer les certifications. D’ailleurs sur certains MOOCS, certaines parties du cours ne sont pas accessibles gratuitement, comme le souligne le post de Couserajunkie « Free MOOCs ? Forget about it ». Jusqu’au bouton LinkedIn qui disparaît si on n’a pris l’option de certification payante …

C’est à ce moment-là que l’on a vu fleurir les SPOCs (Small Private Online Course : cours en ligne privé en petit groupe). Ces formations, en général plus courtes, sont de plus proposées en entreprise comme alternative aux cours en présentiel. Les professeurs qui conçoivent ces cours s’appuient sur des contributions d’entreprises pour créer du contenu tourné vers les secteurs à forte demande (commerce, analyse des données, technologies numériques). Coorpacademy , en revanche, parie sur un nouveau paradigme, au lieu de proposer des séquences de formations continue de 3 jours, 2 semaines ou six mois, cette start-up propose « des apprentissages au fil de l’eau, quand un peu de temps se libère, dans les transports en commun ou en attendant un rendez-vous » comme le souligne Christophe Bys dans son article d’Usine digitale. C’est la méthode Apple avec iTunes : « Il change les règles du jeu en pariant non pas sur la gratuité, mais sur la fragmentation de l’usage ». De plus, un ‘protocole pédagogique inversé’ (le cours commence par un quizz, l’étudiant vérifie ensuite les réponses), permet de prendre en compte l’hétérogénéité des personnes qui suivent la formation. Chacun suit en fonction de ses besoins, de ces lacunes et peut rejoindre ensuite une communauté de groupe où la compétition peut se transformer en coopération, les apprenants d’hier pouvant se transformer en coach pour aider les nouveaux venus …

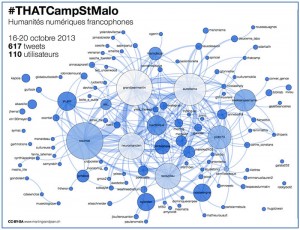

Les Mooceurs peuvent aussi avoir une démarche collective, comme le remarque Matthieu Cisel dans son post « L’avenir des MOOC passe-t-il par l’entreprise ?». Dans une structure, association, entreprise, un groupe de personnes peut se saisir d’un MOOC pour créer des dynamiques collectives, souvent dans une démarche ‘bottom-up’. Le MOOC peut être l’occasion de travailler un point ensemble : la gestion de projet, le prise de parole en public, la statistique, etc. Pour Matthieu Cisel, « l’avenir des MOOCs se trouve dans leur intégration, formelle ou non, dans les cursus de formation initiale ou continue ».

Des avancées pédagogiques et technologiques

Des avancées pédagogiques et technologiques

- Un cours de droit sur Facebook Live

Bruno Dandero, professeur de droit des affaires à Paris 1 Panthéon-Sorbonne diffuse ses cours magistraux en direct sur Facebook Live. Au lieu d’utiliser une plate-forme pédagogique privée ou publique (Coursera, edX ou FUN), cet enseignant élargit son audience des 300 étudiants de son cours à des milliers d’internautes du réseau social ‘massif’, sans inscription spécifique ni identifiants autres que ceux de Facebook. Comme le souligne Paul Conge dans l’Etudiant, ces interactions et contributions (remarques, liens hypertextes et questions juridiques) finissent par constituer un « document pédagogique enrichi ». Comme le dit le Pr Dandero, commentant les 25 000 vues de sa première vidéo « Ce qui me plait c’est de donner accès aux cours à des personnes qui ne sont pas inscrites à l’université ». Son audience est internationale et francophone (Vietnam, Madagascar, Afrique noire). Mais, malgré tout, un cours de droit de 3e année, ça demande des prérequis » …

- L’intelligence artificielle s’invite sur les MOOCs : les ‘chatbots’ assistants pédagogiques

De nombreux enseignants américains utilisent de plus en plus des fonctionnalités d’intelligence artificielle (Siri d’Apple, Alexa d’Amazon, Watson d’IBM) pour les assister dans leurs cours en ligne. Ces chatbots, répondent aux questions, rappellent à l’ordre les étudiants pour certaines tâches ou échéances et peuvent animer des débats en ligne … Évidemment, cela risque de faire disparaître les ‘teaching assistants’, ces étudiants que Karen Head se plaignait de ne pouvoir rémunérer correctement dans son MOOC … Mais comme l’explique Donald sur le post de Wildfire Learning, cela permet aux assistants humains de se focaliser sur les questions intéressantes et créatives quand les ‘bots’ se chargent des questions récurrentes (à Georgia Tech, 10 000 par semestre pour 350 étudiants).

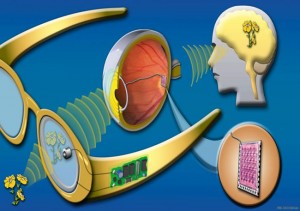

- L’émergence de la réalité virtuelle dans la classe

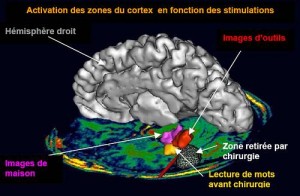

L’importance prise par la formation professionnelle dans l’enseignement à distance implique l’acquisition de compétences plus pratiques que les seules notions théoriques émises par les vidéos des cours en ligne. Malgré le jeu d’acteur des enseignants et leurs exploits graphiques sur les tableaux, noirs ou blancs, il faut souvent beaucoup d’imagination pour se représenter les choses enseignées … C’est là qu’intervient la réalité virtuelle immersive. De la l’école primaire à la formation des chirurgiens en Irlande en passant la construction de maisons durables en Chine, sans oublier évidemment, la simulation du pilotage d’un avion, les casques de réalité virtuelle emmènent les apprenant sur le ‘terrain’. Pour les enfants, Facebook et Google se partagent le marché. Avec Time Machine de Facebook social VR, les élèves se retrouvent dans la préhistoire près des dinosaures avec une application de type ‘Jurassic Park’. Dans Expeditions, du kit Google, le professeur se transforme en guide au sommet de l’Everest ou sur Mars … La Rady School of Management, de l’Université de San Diego en Californie a déjà son programme virtuel sur VirBela, la plateforme de réalité sociale virtuelle. En s’y connectant, les étudiants sont plongés dans des situations de cas concrets et doivent interagir comme dans un jeu vidéo …

Les MOOCs n’ont pas révolutionné l’enseignement supérieur : le ‘mammouth’ est difficile à renverser … Ce dispositif a néanmoins bousculé un certain nombre de rigidités pédagogiques et fait bouger les lignes dans les formations initiales et continue. L’enseignement initial se retrouve même impacté par cette innovation à travers la pratique de la ‘classe inversée’, de plus en plus adoptée dans certains cours. Cette pédagogie qui encourage les apprenants à se familiariser avec un certain nombre de notions sur internet avant d’assister aux cours et d’en débattre ensuite avec leurs enseignants, a inspiré la plateforme FUN qui propose aujourd’hui aux lycéens de terminale des MOOCs de préparation à l’enseignement supérieur sur des matières sensibles (Maths, droit, SHS, sport). Cela leur permettra d’être prêts au niveau des prérequis ou ‘attendus’ pour certaines filières comme le prévoit la prochaine réforme de l’admission à l’université.

Siemens, George ; Gasevic, Dragan ; Dawson, Shane. – Preparing Digital University :a review of the history and current state of distant, blended, and online learning. – Athabasca University, University of Edinburgh, University of Texas Arlington, University of South Australia. – Bill & Melinda Gates Foundation, February 2015. (pdf).

Cisel, Matthieu. – MOOC : pour la Révolution, on repassera. – Educpros : La révolution MOOC, 22/04/15

Cisel, Matthieu. – L’avenir des MOOC passe-t-il par l’entreprise ? – Educpros : La révolution MOOC, 23/06/15

Free MOOCs ? Forget about it. – Courserajunkie, 26/05/15

Trujillo, Elsa. – La formation professionnelle, l’avenir des MOOC. -Microsoft RSLN, 26/08/15

Bys, Christophe. – Coorpacademy veut appliquer la méthode Apple à la formation professionnelle. – Usine digitale, 01/09/15

Brasher, Joan. - What makes students stick with a MOOC? – Research News Vanderbilt, 26/02/16

Conge, Paul. – Un prof de droit donne des cours en direct sur Facebook. – L’Etudiant, 23/09/16

Merry, Peter. - Immersive Virtual Reality: Online Education for the Next Generation. – Converge, 28/09/16

Les universités britanniques lancent les premiers MOOCs certifiants. – Le Monde, 18/10/16

MOOCs : les chiffres qui comptent. – Managexam, 01/11/16

Bot teacher that impressed and fooled everyone. – Wildfire Learning, 02/08/17

Duthion, Brice – MOOC, SPOC, COOC et autres tutos, ou les aventures en ligne d’un formateurs voulant se former … -Etourisme.info, 03/10/17

Frank, Cyrille. – Mooc, elearning, gamification, serious-game … innovations réelles ou mirages ? – Médiaculture, 14/10/17

Boeva, Yana. – Book review: Disrupt This! MOOCs and the Promise of Technology by Karen Head. – Impact of Social Sciences, 22/10/17

Antaya, Felipe. – Ouvrir les murs de la classe avec le numérique. – École branchée, 23/10/17

Miller Marine. – Les MOOC font pschitt. – Le Monde, 23/10/17